Jonas Bauters

‘Een onschuldige foto? Hoe AI online kindermisbruik in de hand kan werken’

‘Online foto’s kunnen verzameld worden in gigantische collecties. Terwijl traditionele risico’s al relatief bekend zijn, heeft de opkomst van artificiële intelligentie voor een hele resem aan bijkomende gevaren gezorgd’, waarschuwt expert cyber security Jonas Bauters. Hij geeft een aantal tips op voor online fotohygiëne om de risico’s te beperken.

We delen allemaal wel eens een foto van onszelf of onze kinderen via sociale media. Daarnaast worden foto’s ook vaak op de website van een sportvereniging, school, of jeugdbeweging geplaatst, beschikbaar voor iedereen met een internetverbinding. Traditionele risico’s die daarmee gepaard gaan zijn de meesten onder ons wel bekend, waaronder bijvoorbeeld kinderpornografie op het dark web. Met de opkomst van artificiële intelligentie komen er echter een aantal nieuwe risico’s naar boven waar we niet meteen bij stilstaan.

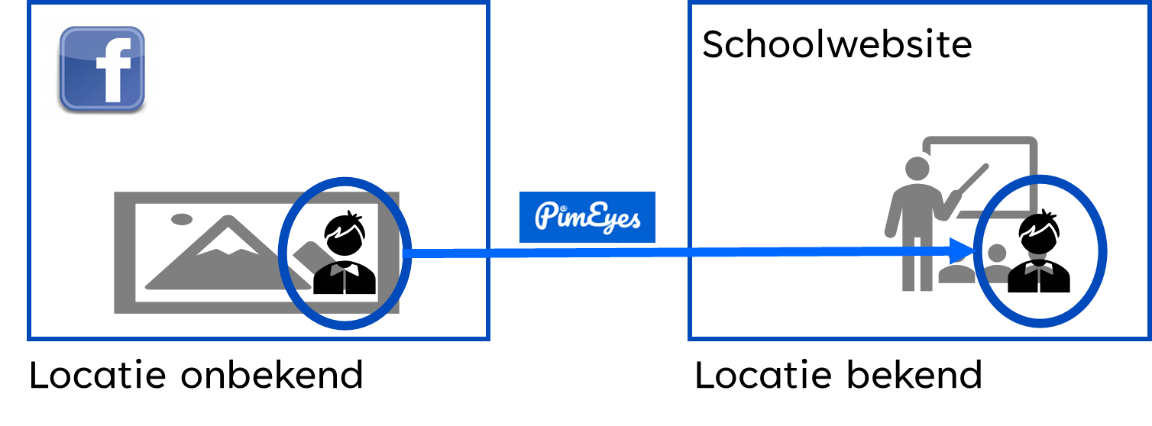

Gezichtsherkenning

Verschillende onlinediensten hebben een businessmodel opgebouwd gebaseerd op het verzamelen van zoveel mogelijk foto’s van websites en zelfs sociale media. Een voorbeeld daarvan is ClearView AI, een gezichtsherkenningsservice gericht op o.a. politiediensten of overheden. Met een foto van een verdachte kunnen ze in hun database gaan zoeken naar andere foto’s waar hetzelfde gezicht op terug te vinden is. Voor de gewone burger is er echter een gelijkaardige service beschikbaar, namelijk PimEyes. De resultaten zijn angstaanjagend accuraat; we konden een persoon herkennen op foto’s waar hij/zij een hoofddeksel of mondmasker droeg die delen van het gezicht bedekten. Er is natuurlijk niks dat de gebruiker belet hier de foto van een kind te uploaden. Bij wijze van voorbeeld gebruiken we een stockfoto waaruit we het gezicht van het middelste kind in andere foto’s willen zoeken:

Het algoritme geeft natuurlijk een aantal foto’s terug die uit dezelfde fotocollectie lijken te komen, maar ook andere foto’s waren beschikbaar in de resultaten, soms met andere kinderen die er sterk op lijken. Wat voor risico’s gaan hiermee nu gepaard?

- Met een foto van een persoon/kind kunnen andere foto’s gevonden worden die misschien een hint naar hun locatie bevatten (bijvoorbeeld door metadata, herkenbare elementen of de bron van de foto).

- De resultaten kunnen foto’s bevatten waarvan je zelf niet eens afwist, denk maar aan wraakporno bijvoorbeeld. Dit fenomeen waarbij naakt- of seksueel getinte beelden worden verspreid zonder toestemming van de betrokken persoon is op zich al erg genoeg. Combineer dit soort beelden als resultaat van een gezichtsherkenning met kinderfoto’s en de uitkomst wordt nog dramatischer.

- Het kan ook iets minder extreem natuurlijk. Net zoals werkgevers een sollicitant eerst “googlen”, is het mogelijk dat in de toekomst de sollicitant eens door de gezichtsherkenning gehaald wordt. De resultaten kunnen gênante foto’s bevatten die je liever niet zou delen met een mogelijke werkgever.

Het hoeft dus geen verdere uitleg dat dit soort service een kolfje naar de hand van stalkers of afpersers is.

Genereren van nieuwe afbeeldingen

De voorbije weken zijn zaken zoals ChatGPT en DALL-E bijna niet uit het nieuws geweest. We kunnen nu vragen stellen die door artificiële intelligentie beantwoord worden of met een korte omschrijving een afbeelding laten genereren. Het is echter ook mogelijk om een bestaande afbeelding te transformeren; eigenlijk Photoshop via artificiële intelligentie. OpenAI, het bedrijf achter bovenstaande tools, verklaart dat ze gewelddadige en seksuele inhoud gefilterd hebben bij het trainen van hun model. Zonder deze bescherming zou de applicatie per ongeluk gevoelige afbeeldingen kunnen genereren, zelfs bij een onschuldig verzoek. Voor deze test gebruiken we opnieuw dezelfde stockfoto, waarbij we enkel de bovenste helft behouden. Hierbij vragen we DALL-E om de foto aan te vullen zodat het lijkt alsof de kinderen een leuke dag aan zee doorbrengen in zwemkledij; een relatief onschuldige vraag. Een aantal van de resulterende afbeeldingen staan hieronder vervaagd weergegeven:

De eerste twee afbeeldingen lijken inderdaad een leuke dag aan zee, met een schop, emmer, en opblaasband. De derde afbeelding is al iets verrassender; hierbij krijgen de kinderen plots shorts en heeft het middelste kind zelfs een boezem gekregen. Dit is dus het resultaat met een onschuldige vraag en ingebouwde bescherming tegen het genereren van gevoelige afbeeldingen.

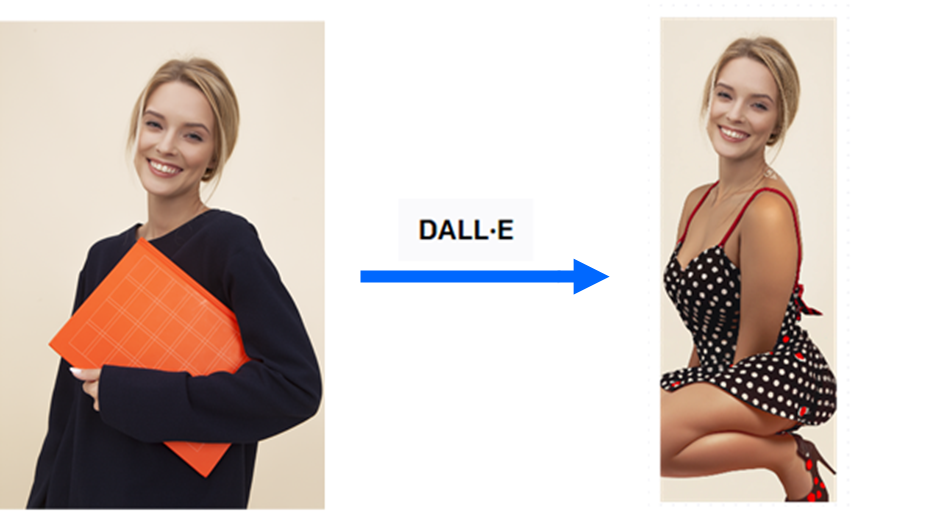

Laten we eens zien wat het resultaat is met een iets suggestievere vraag. Uiteraard gebruiken we in dit geval een andere stockfoto. Dit keer vragen we om een pin-up model te genereren:

Dit is wat we kunnen creëren met een compleet willekeurige foto, onbestaande Photoshop skills, en een paar minuten tijd. Niks belet internetgebruikers deze acties toe te passen op foto’s van kinderen.

Het gebruik of misbruik van artificiële intelligentie kan zelfs nog verder gaan. Andere toepassingen hebben niet dezelfde beperkingen opgelegd aan de trainingsdata voor hun model en bevatten dus wel seksuele inhoud. Lensa is een populaire app die op basis van een aantal selfies nieuwe foto’s van de gebruiker kan genereren. Zo kan je er plots uitzien als astronaut of superheld. In het geval van vrouwelijke gebruikers zijn de resultaten vaak iets schaarser gekleed, wat resulteert uit vooroordelen ingebouwd in het model door de trainingsdata. Deze zelfde vooroordelen blijven van toepassing wanneer kinderfoto’s gebruikt worden en resulteren in suggestieve of zelfs naaktbeelden.

Terwijl deze afbeeldingen “per ongeluk” gegenereerd worden, zijn bepaalde toepassingen zelfs expliciet gericht op het maken van naaktbeelden. Zogenaamde deepfakes zijn afbeeldingen of video’s die met artificiële intelligentie gegenereerd worden en de stem of het gezicht in bestaand beeldmateriaal kunnen vervangen. Vaak gaat het om vervalste pornografische video’s waarbij het gezicht van een beroemdheid in de video wordt geplaatst. Het gebruik van dit soort toepassingen om beeldmateriaal te maken van personen, meestal vrouwen, die de gebruiker persoonlijk kent neemt echter toe. Daarenboven is het onwaarschijnlijk dat dit soort technologie niet zal toegepast worden op foto’s van tieners of kinderen.

Het lijdt geen twijfel dat artificiële intelligentie en gerelateerde technologieën aanwezig zullen blijven en alleen maar in gebruik toenemen. Naast alle nuttige toepassingen en ontwikkelingen, is er ook het onvermijdelijke risico op misbruik, waardoor bewustwording van de gevaren alle belang heeft. Daarnaast kunnen we proberen de risico’s zoveel mogelijk te beperken en anderen te informeren.

Tips voor online fotohygiëne

Een aantal algemene tips waar je rekening mee kan houden:

- Bepaal voor jezelf en jouw kinderen hoeveel informatie je bereid bent online te delen. Maak dit verlangen ook duidelijk aan anderen en respecteer hun wensen. Anderen vinden het misschien niet leuk dat je een foto van hen op jouw sociale media plaatst, zelfs al gaat het om een groepsfoto.

- Foto’s waarop de persoon onherkenbaar is (bijvoorbeeld achteraan of van opzij gemaakt of met een emoji voor het gezicht) kunnen een goed alternatief zijn.

- Deel foto’s via privékanalen in plaats van sociale media. Stuur bijvoorbeeld de foto’s van het verjaardagsfeestje door via mail of een chatbericht.

- Indien je toch een foto op sociale media plaatst, beperk het doelpubliek. Ken je trouwens al je vrienden op Facebook ook in het echte leven?

- Probeer metadata en andere informatie die een locatie kan weggeven zoveel mogelijk te vermijden.

- Op https://www.ikbeslis.be/ vind je nog meer tips terug voor jongeren, ouders, en leerkrachten.

Conclusie

Online foto’s kunnen verzameld worden in gigantische collecties. Terwijl traditionele risico’s al relatief bekend zijn, heeft de opkomst van artificiële intelligentie voor een hele resem aan bijkomende gevaren gezorgd. Verzamelingen foto’s kunnen misbruikt worden bij gezichtsherkenning of als basis dienen voor het genereren van voorheen onbestaande afbeeldingen. De gevaren kunnen niet alleen in het heden tot uiting komen, maar eveneens jaren in de toekomst. Het gaat daarom dus niet alleen om het beschermen van de kinderen op dit moment, maar ook het beschermen van de tieners en volwassenen die ze later zullen worden.

Jonas Bauters is cyber security manager bij NVISO, waar hij gespecialiseerd is in het uitvoeren van gesimuleerde cyberaanvallen en ethical hacking.

Een Engelse versie van deze bijdrage verscheen op de blog van Jonas Bauters van NVISO.

Fout opgemerkt of meer nieuws? Meld het hier