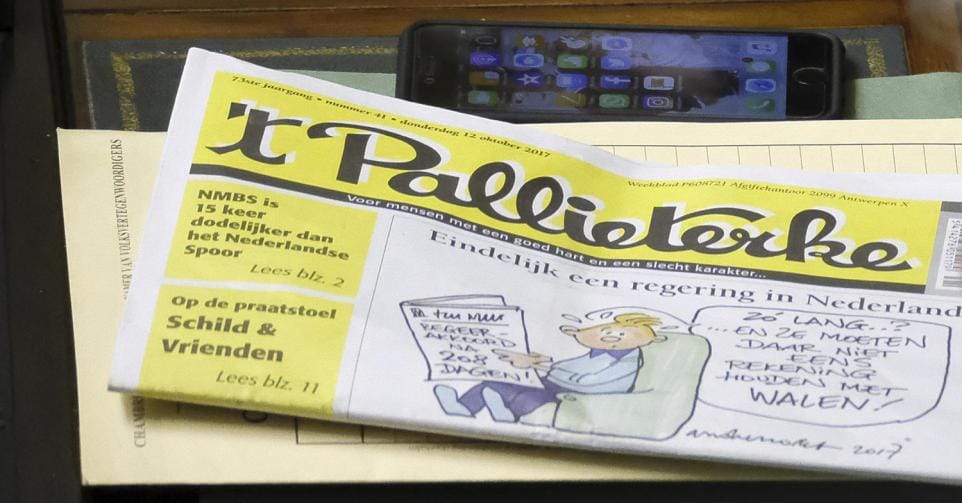

Het rechts-conservatieve weekblad ‘t Pallieterke beschuldigde het Planbureau en federaal klimaatcentrum Cerac ervan dat ze een recent rapport voor driekwart door artificiële intelligentie zouden hebben laten schrijven. Dat klopt niet, en het incident kadert in een lange lijst van problemen veroorzaakt door falende AI-detectietools.

‘België betaalt ambtenaren om ChatGPT alarmerend klimaatrapport te laten schrijven’ kopte PAL NWS, de online poot van ’t Pallieterke, begin deze maand. Het onderwerp van de controverse was een rapport dat eind september gepubliceerd werd door het Federaal Planbureau en Cerac, het nationale Centrum voor Risicoanalyse van Klimaatverandering. Specifiek werd de mogelijke impact van verschillende scenario’s van klimaatverandering op macro-fiscaal vlak onderzocht. In het slechtste klimaatscenario, zo berekende het rapport, kon de schade aan de Belgische economie oplopen tot vijf procent van het bbp. Maar dat rapport zou volgens PAL NWS ‘grotendeels door kunstmatige intelligentie zijn geschreven’.

Online werd het sappige verhaal over het ‘ChatGPT-klimaatrapport’ druk becommentarieerd. De meeste reacties grepen de vermeende rol van AI aan om ook de inhoud af te serveren als ‘fake’ of overdreven. P-Magazine nam het verhaal van PAL NWS over onder de titel ‘Klimaatpaniek uit de computer: Belgisch rampenrapport blijkt door AI geschreven’. In het stuk wordt gespeculeerd dat de ‘dramatische toon’ van het rapport te wijten zou zijn aan AI-gebruik: ‘Ook ChatGPT klinkt soms als een oververhitte klimaatactivist op sojamelk – omdat het de bot zo werd aangeleerd, uiteraard.’ Antwerps gemeenteraadslid Tim Tubbax van Vlaams Belang reageerde erg verontwaardigd op Facebook: ‘Zo probeert links ons dus het geld uit onze zakken te kloppen… met fake klimaatrapporten geschreven door AI.’

Maar waar is het verhaal over een ‘met ChatGPT geschreven klimaatrapport’ precies op gebaseerd? En klopt het wel?

‘Controlesoftware’

Dat officiële rapporten tegenwoordig soms geschreven worden met behulp van artificiële-intelligentietools is niet uit de lucht gegrepen. Deze zomer nog ontstond er ophef nadat adviesbureau Deloitte een rapport maakte in opdracht van het Australische ministerie van Arbeid waarin onbestaande literatuurverwijzingen en verzonnen citaten stonden. Het gaat om typische voorvallen van ‘hallucinaties’ door AI-chatbots. In een geüpdatete versie van het rapport werden die referenties geschrapt en gaf Deloitte toe dat bij het technische werk gebruik was gemaakt van een generatieve AI-tool.

Behalve AI-detectietools, bestaan er ook ‘AI-humanizers’: apps die beweren dat ze AI-producten kunnen ‘vermenselijken’.

Het zijn dat soort details – gehallucineerde referenties, delen van een prompt of antwoord uit een chatbot die per ongeluk opgenomen zijn in de tekst – die daadwerkelijke bewijzen vormen dat teksten met behulp van AI zijn geschreven. Wanneer we de literatuurlijst van het recente klimaatrapport dubbelchecken, is daarvan alvast geen sprake: alle referenties zijn authentiek.

In het PAL NWS-artikel wordt verwezen naar ‘een controlesoftware’ die zou hebben vastgesteld dat het Planbureau ‘het rapport voor 74 procent [bleek] te hebben geschreven met ChatGPT’. Op het X-profiel van de auteur, en als illustratie bij een gelijkaardig artikel op de conservatieve Franstalige nieuwssite 21news dat nadien offline werd gehaald, stond een screenshot van de website waarop datzelfde percentage te zien is: JustDone.

Cypriotisch internetbedrijf

JustDone is een zogenaamde ‘AI-detectietool’. Je kunt er lappen tekst of complete artikels uploaden, waarna de tool berekent welk percentage daarvan tekenen vertoont van AI-generatie. Achter JustDone schuilt een internetbedrijf uit Cyprus dat ook apps voor taalcursussen en voor een betere slaapkwaliteit aanbiedt.

Vaak volstaan enkele opzettelijke taal- of spelfouten om een AI-detector te misleiden.

Er zijn tegenwoordig erg veel AI-detectors. Ze hebben namen als ‘Originality’, ‘CopyLeaks’, of ‘GPTZero’ – en dus ook ‘JustDone’. Vaak ontstonden de detectors uit bestaande, gevestigde ‘plagiaatcheckers’ zoals Turnitin. Een parallelle industrie vormen de ‘AI-humanizers’: apps die beweren dat ze AI-producten kunnen ‘vermenselijken’. Wie daadwerkelijk een schooltaak door een AI-chatbot heeft laten schrijven, kan er zo’n humanizer-app op loslaten die vervolgens alles herschrijft in een stijl die – door gewone lezers of door detectors – niet langer als artificieel zou mogen herkend worden. Het succes van de bedrijven die AI-detectie- en AI-humanizer-diensten aanbieden, wortelt in het ondertussen wijdverspreide gebruik van AI-teksten in scholen en in de academische wereld – en de onrust die heerst over de impact daarvan.

Maar soms is de remedie erger dan de kwaal. Recent academisch onderzoek naar AI-detectors wijst uit dat de tools veel fouten maken en makkelijk om de tuin te leiden zijn. Vaak volstaat het om enkele opzettelijke taal- of spelfouten toe te voegen aan een tekst om een AI-detector te misleiden. Een bepaald percentage van daadwerkelijke AI-teksten raakt dus sowieso niet als dusdanig herkend.

Maar ook het omgekeerde fenomeen komt voor: valspositieve resultaten, waarbij door mensen geschreven teksten onterecht gemarkeerd worden als AI-product. Al in 2024 verschenen schampere artikels over hoe AI-detectors zelfs de Amerikaanse grondwet en bijbelpassages als ‘AI-teksten’ hadden bestempeld. Auteurs die niet in hun moedertaal schrijven, die vertaaltools gebruikten, of wier schrijfstijl toevallig de kenmerken vertoont waar de detectors tijdens hun patroonherkenning naar op zoek gaan, krijgen vaker te maken met valspositieve resultaten.

Verzonnen klanten

We contacteerden de journalist van het PAL NWS-artikel op 8 oktober met enkele vragen over de door hem aangewende tool, maar hij liet weten niet te willen reageren. Een dag later verscheen evenwel een nieuw artikel op PAL NWS, over AI-detectietools, dat duidelijk maakt wat aan de basis ligt van het vertrouwen dat de auteur stelde in JustDone en van de claims over het ‘door ChatGPT geschreven rapport’.

‘JustDone heeft veel universiteiten als betalende klanten’, valt te lezen in het nieuwe PAL NWS-artikel. Die inschatting lijkt gebaseerd op de logo’s van een dozijn universiteiten die op de site van JustDone prijken, waaronder ook prestigieuze Amerikaanse instituten als MIT, Johns Hopkins, Cornell en UCLA. Maar wie oplet, merkt dat het enige wat het bedrijf daar werkelijk over beweert, is dat hun diensten ‘vertrouwd worden door studenten en academici aan drieduizend universiteiten’. Via e-mail bevestigt een woordvoerder van JustDone aan Knack dat ze geen institutionele contracten hebben met de universiteiten zelf, maar dat het gaat om een verwijzing naar individuele studenten.

Sommige studenten maken video-opnames van hun schermactiviteit tijdens het schrijfproces, om te bewijzen dat ze wel degelijk zélf de auteur zijn van hun schooltaken en essays.

Het is niet het enige misleidende element waarmee JustDone klanten probeert te ronselen. Elders op de site vinden we een zestal ‘testimonials’ van tevreden gebruikers – studenten, doctorandi en onderzoekers – die de producten van JustDone bejubelen. De foto’s van de zes getuigen blijken evenwel willekeurige stockfoto’s uit onlinedatabanken. Op onze vraag naar een verklaring daarvoor ontvingen we geen reactie meer van JustDone.

Wie de kleine lettertjes van de gebruiksvoorwaarden van JustDone leest, ziet de bui al hangen. Onder de hoofding ‘belangrijke disclaimers’ valt te lezen: ‘Wij geven geen garantie dat de service aan uw eisen zal voldoen, […] vrij van fouten zal zijn, de resultaten die kunnen worden verkregen door het gebruik van de service nauwkeurig of betrouwbaar zullen zijn, of de kwaliteit […] aan uw verwachtingen zal voldoen of u enig voordeel zal opleveren.’ Samengevat: wie de resultaten van JustDone vertrouwt, doet dat op eigen risico en krijgt geen enkele garantie dat ze ook daadwerkelijk kloppen.

‘Omzeil alle detectors’

Toch doen we nog wat extra tests met de door PAL NWS gebruikte AI-detector. Wanneer we een persbericht van het Planbureau uit 2015 over indicatoren van duurzame ontwikkeling uploaden, markeert JustDone die tekst voor 73,64 procent als ‘waarschijnlijk gegenereerd door AI’. Een excerpt uit een studie over de vergrijzing uit 2017 wordt zelfs voor 89,75 procent als een AI-product bestempeld. Onmogelijk natuurlijk, want beide teksten dateren uit een tijdperk waarin nog geen sprake was van ChatGPT of van AI-gegenereerde teksten.

Is JustDone dan gewoon een laagkwalitatieve tool, die aan de lopende band fouten maakt en valspositieve resultaten ophoest? Mogelijk is er meer aan de hand. De website biedt namelijk – naast AI-detectie – ook diensten aan voor het ‘humaniseren’ van teksten. De resultaten over zogenaamde ‘AI-rapporten’ van het Planbureau krijgen van JustDone meteen een waarschuwing en een opvallend aanbod mee: ‘Deze tekst kan door detectors worden gemarkeerd. Maak hem ondetecteerbaar met onze Humanizer.’ Daarnaast vind je een extra uitnodiging voor een JustDone-dienst die je teksten belooft te ‘humaniseren’ tot ‘100 procent originele tekst met 0 procent AI-inhoud’. ‘Omzeil alle detectors’, staat er nog bij als uitsmijter.

Het noopt tot de vraag of JustDone de valspositieve resultaten niet artificieel opdrijft om bijkomende betalende diensten te slijten. Een student die voor een paper daadwerkelijk een beroep deed op ChatGPT, en bang is om bij zijn professoren door de mand te vallen, kun je met zo’n hoog percentage bang maken en zo als klant aan je binden.

Valspositieve resultaten

Ongefundeerde beschuldigingen van valsspelen of van niet-geopenbaard gebruik van AI-tools zijn de laatste jaren schering en inslag. In Amerikaanse media kun je getuigenissen lezen van copywriters die hun job verloren omdat een detectietool hun teksten onterecht als AI beoordeelde. Onderwijskundige tijdschriften waarschuwen al jaren de bestuurders van scholen en universiteiten voor het fenomeen. Regelmatig nog komen studenten in conflict met onderwijsinstellingen die gebruik maken van detectordiensten zoals Turnitin, en die de studenten – volgens hen onterecht – van AI-gebruik beschuldigen.

Sommige studenten, zo rapporteerde The New York Times in mei 2025, zijn daarom zelfs begonnen met het maken van video-opnames van hun schermactiviteit tijdens het schrijfproces, om te bewijzen dat ze wel degelijk zélf de auteur zijn van hun schooltaken en essays. Verschillende universiteiten die in het verleden een beroep deden op AI-detectors zijn daar ondertussen weer van afgestapt. Georgetown University deed dat bijvoorbeeld al in oktober 2023, vanuit ‘bezorgdheden over de nauwkeurigheid van de tool en de overtuiging dat de nadelen van valspositieve resultaten erger zijn dan de voordelen van de tool’.

‘Het lijkt ons een gevaarlijke tendens om via dergelijke onbetrouwbare tools wetenschappelijk onderzoek in een kwaad daglicht te stellen.’

De voorbije jaren is er ook best wat academisch onderzoek verschenen over de betrouwbaarheid van AI-detectors. Die onderzoeken zijn vernietigend voor de accuratesse van de detectietools. De schaarse studies die ook specifiek de prestaties van JustDone onderzochten, rangschikken de site bij de onbetrouwbaarste van de onderzochte tools, vooral wegens het onterecht herkennen van door mensen geschreven teksten als ‘AI’. In onlinerecensies lees je herhaaldelijk dezelfde kritieken: gebruikers die klagen dat hun eigen, zelfgeschreven teksten door JustDone niettemin als ‘AI’ worden bestempeld, of dat het herhaaldelijk uploaden van dezelfde tekst telkens een ander percentage als resultaat oplevert.

AI-charter

Gebruikt Cerac dan helemaal géén artificiële-intelligentietools? Toch wel. PAL NWS verwijst er ook naar als rechtvaardiging: ‘De directie van Cerac vertelde vorig jaar immers zelf in de Kamercommissie – waar ze haar werk kwam voorstellen – aan de parlementairen dat ze met AI zouden werken voor het maken van hun risicoanalyse. Dat was de aanleiding om het rapport op AI te controleren en na te kijken hoeveel AI ze gebruikten.’

Het voornoemde gebruik van AI gaat evenwel niet over de recente economische risicoanalyse die door het Planbureau werd uitgevoerd, maar over een compleet ander rapport. In een hoorzitting in de commissie voor Energie, Leefmilieu en Klimaat op 14 januari 2025 legde Cerac-directeur Luc Bas uit dat het centrum gebruik zou maken van artificiële-intelligentietools, maar dan specifiek bij het opmaken van een overzicht van de honderden bestaande lokale initiatieven en plannen voor adaptatie in de strijd tegen de gevolgen van de klimaatverandering.

‘Doordat de schaal en het aantal te analyseren documenten zodanig groot was, werd er bewust geopteerd om een eerste fase te ondersteunen door gebruik te maken van AI’, laat Cerac weten in een reactie. ‘Artificiële intelligentie kan worden gebruikt ter verificatie van documenten en ter ondersteuning, maar Cerac werkt met partners samen en zal al zijn bronnen grondig verifiëren. Indien AI wordt gebruikt, is dat louter ter ondersteuning en wordt met AI grondig omgesprongen volgende de deontologische codes die rond AI werden opgesteld voor het openbaar ambt.’

Dat laatste is een verwijzing naar de publicatie ‘Artificiële intelligentie bij de overheidsdiensten: charter voor een verantwoord gebruik’, die inzet op transparantie en menselijke controle bij gebruik van AI. De tekst is aangenomen door tientallen federale overheidsorganisaties, waaronder het Federaal Planbureau, en in juli 2025 ondertekend door minister van Modernisering van de Overheid Vanessa Matz (Les Engagés).

‘Ongefundeerd en nepnieuws’

In een reactie aan Knack reageert het Planbureau scherp op de aantijgingen in PAL NWS. Ze noemen het artikel van PAL NWS ‘volledig uit de lucht gegrepen, ongefundeerd en nepnieuws’. Het Planbureau ontkent nogmaals voor het klimaatrapport gebruik te hebben gemaakt van ChatGPT of andere AI-chatbots. Het liet de literatuurstudie uit het rapport zelf nog eens door verschillende AI-detectorsites onderzoeken, die telkens uitwezen dat 0 procent afkomstig was van AI – zelfs JustDone kwam tot dat oordeel. De rest van de analyse, zegt het Planbureau, komt uit eigen onderzoeksmodellen: ‘AI is niet in staat om dit werk te doen. Bovendien werd de inhoud van het rapport opgesteld door 2 experts en nagelezen door zowat 10 experts van zowel het Planbureau als van Cerac. Daarbij werden constant passages geschrapt en aangepast.’

Het Planbureau besluit dat ze zich ‘bijgevolg serieuze vragen stellen bij de journalistieke deontologie’ van de journalist: ‘Het lijkt ons alvast een gevaarlijke tendens om via dergelijke onbetrouwbare tools wetenschappelijk onderzoek in een kwaad daglicht te stellen. Iedereen heeft het recht om zijn mening te geven, maar in dit geval lijkt het ons bewust te gaan om verspreiden van valse informatie om zowel de instelling, de publicatie als de resultaten in diskrediet te brengen.’