Censureert de regering haar burgerenquête met artificiële intelligentie?

Later dit jaar organiseert de federale regering een burgerenquête over de institutionele toekomst van België. N-VA beweert nu dat ‘ongewenste meningen’ geweerd zullen worden via AI. Klopt dat?

Iedere week zoekt Knack naar misleidende informatie op het internet.

Vorige week, in de luwte van het parlementaire zomerreces, lanceerde de N-VA een opvallend persbericht. De partij toont zich daarin sceptisch over het online dialoogplatform waarop de burger, het maatschappelijk middenveld en lokale overheden binnenkort inspraak zullen krijgen over de modernisering van de Belgische staatsstructuur. ‘Uw mening welkom? Enkel als ze de paars-groene filter passeert’, stelt de N-VA daarover, gebaseerd op een welbepaalde passage in een nota aan de ministerraad over het dialoogplatform. Daarin valt te lezen dat de resultaten van de burgerenquête verwerkt worden met artificiële intelligentie (AI), en dat die behandeling ‘vooroordelen, discriminatie en de uitsluiting van niet-genormeerde uitspraken’ zal vermijden.

N-VA-Kamerlid Sander Loones klaagt aan dat hij in het parlement geen antwoord kreeg op zijn vragen om klaarheid te scheppen over wat die AI-behandeling precies inhoudt, en wat beschouwd wordt als ‘vooroordelen’, ‘discriminatie’ of ‘niet-genormeerde uitspraken’. ‘Het lijkt er sterk op dat niet alle meningen meetellen voor de Vivaldisten’, zo stelt hij. Wat is er precies aan de hand?

AI-behandeling

De aankondiging van een behandeling met artificiële intelligentie is eigenlijk niets nieuws. Ze stond al beschreven in een antwoord dat minister van Binnenlandse Zaken Annelies Verlinden (CD&V) eind mei bezorgde op een schriftelijke vraag van Loones, en kwam eveneens aan bod in de Kamercommissie Grondwet en Institutionele Vernieuwing op 9 juni. Daar vroeg Loones verduidelijking over de AI-behandeling: ‘Ik begrijp daaruit dat een computersysteem de ingezonden informatie zal filteren en zal nagaan of het gaat om genormeerde of niet-genormeerde uitspraken, namelijk of mensen bepaalde zaken mogen zeggen of beter niet zeggen. […] Ik mag hopen dat we zo goed mogelijk proberen om alle meningen ruimte te geven […]. Want als die bezorgdheid niet kan worden weggenomen, zullen er altijd mensen zijn die de indruk hebben dat hun mening aan de kant wordt geschoven door de toepassing van een filter.’

Loones stelde voor om een specifieke sessie te organiseren over de AI-behandeling, opdat de mensen die deelnemen aan het dialoogplatform weten wat er met hun antwoorden zal gebeuren. ‘Dat zal ook de participatiegraad versterken.’

Op die suggestie voor een speciale hoorzitting ging de meerderheid niet in, maar minister Verlinden antwoordde op 9 juni al dat de AI-behandeling ‘zeker geen filtering’ inhoudt. ‘Ik weet niet waar dat vermoeden of die bedenking ontstaan is, want dat is uiteraard niet de bedoeling. De bedoeling is alleen om zo snel mogelijk de informatie die wordt ingewonnen, te verwerken […].’ Het plan is namelijk dat de enquête ook open vragen bevat en het mogelijk maakt om persoonlijke suggesties mee te geven. De grote hoeveelheden aan vrije tekstgegevens die dat oplevert, in de drie landstalen, kunnen met een AI-tool voor semantische analyse automatisch geanalyseerd en in kaart gebracht worden.

Minderheidsgroepen

De passage over het vermijden van ‘vooroordelen, discriminatie en de uitsluiting van niet-genormeerde uitspraken’ bij de AI-behandeling wijst eigenlijk op het tegenovergestelde van het schrappen van meningen. Het drukt de intentie uit om een diversiteit aan opinies te bewaren bij de behandeling van de ruwe data. Het gaat niet om inhoudelijke censuur van antwoorden van burgers, maar juist om de garantie dat ook ‘niet-genormeerde uitspraken’ aan bod kunnen komen.

In tegenstelling tot wat je zou vermoeden, zijn artificiële intelligentie en algoritmes namelijk nooit ‘neutraal’. Bewust of onbewust kunnen vooroordelen in een systeem sluipen. Dat stelde ook ICT-consultancybedrijf Capgemini in een recent rapport met richtlijnen om onbewuste vooroordelen in kunstmatige intelligentie te voorkomen en minderheidsgroepen in de samenleving niet over het hoofd te zien: ‘Het verzamelen van data is mensenwerk. En mensen hebben vooroordelen, bewust of onbewust. En wanneer de data vooroordelen bevat, nemen systemen deze vooroordelen over. […] Als van bepaalde groepen weinig gegevens beschikbaar zijn, heeft kunstmatige intelligentie de neiging deze groepen over het hoofd te zien.’ Zeker wanneer een overheid gebruikmaakt van kunstmatige intelligentie, stelt Capgemini, moet extra alert opgetreden worden om dit soort vooroordelen en discriminatie te vermijden.

De passage over het vermijden van ‘vooroordelen en discriminatie’ drukt juist de intentie uit om een diversiteit aan opinies te bewaren.

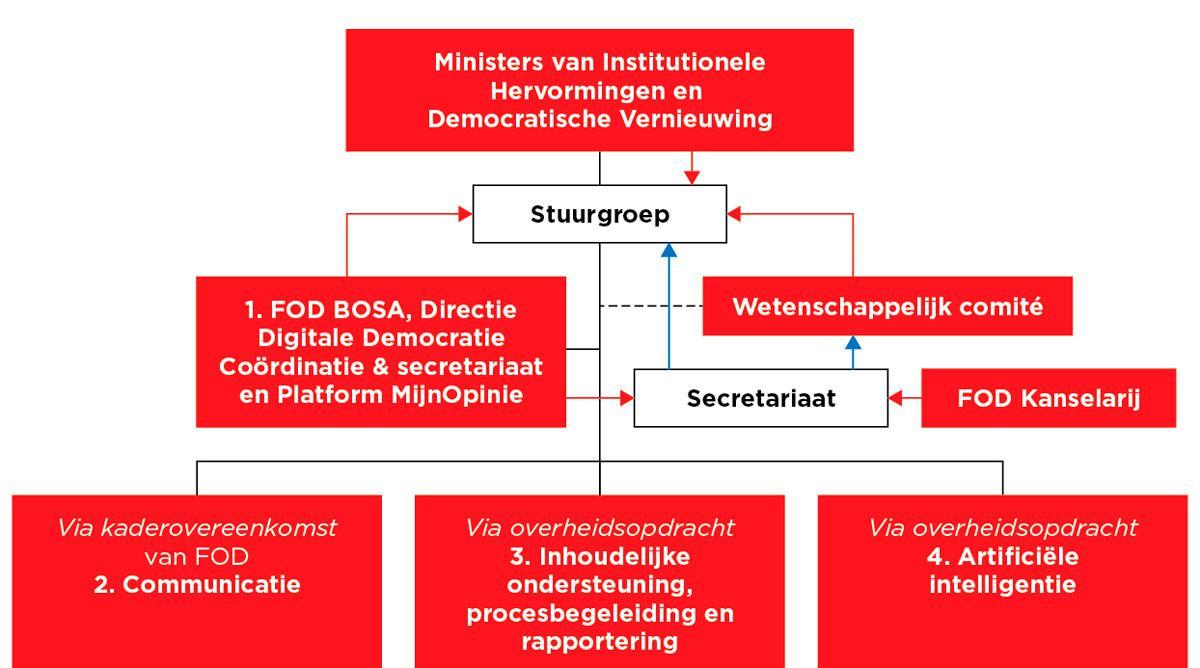

Wie zal bij het dialoogplatform de verantwoordelijkheid dragen voor de AI-behandeling? Wel, dat weten we nog niet. Voor verschillende aspecten van de uitbouw van het platform doet de regering een beroep op externe aannemers, en het bestek voor de aanbesteding voor het luik ‘artificiële intelligentie’ is nog niet klaar. Uit beschikbare documenten valt wel al op te maken dat de overheid rekent op ‘een goede coördinatie en regelmatige wisselwerking’ tussen de verschillende opdrachtnemers van de verschillende luiken, ‘gezien alle elementen met betrekking tot de enquête die de opdrachtnemer zal moeten opstellen een impact hebben op de latere verwerking van de antwoorden (en omgekeerd)’. Indien de federale regering een ‘Vivaldi-filter’ zou willen opleggen, zou dat betekenen dat zowel de stuurgroep, het Wetenschappelijk Comité als de verschillende private aannemers allemaal mee in het complot zitten.

Censuurfilters

Artificiële intelligentie is voor de meeste burgers een bijzonder vaag begrip. Argwaan is begrijpelijk, zelfs lovenswaardig. Het N-VA- persbericht over een ‘Vivaldi-filter’ loopt met zekerheid vooruit op de feiten, maar lijkt vooral bedoeld als knuppel in het hoenderhok, als een vraag om meer transparantie, en gewoon als politiek statement om het wantrouwen in de federale regering uit te drukken.

Dat komt vooral tot uiting wanneer Peter De Roover (N-VA-fractievoorzitter in de Kamer) aan het woord komt: ‘We hebben al geregeld grote burgerbevragingen in dit land. We noemen die: verkiezingen. Maar Vivaldi respecteert zelfs de uitslag van die verkiezingen niet, de premier komt uit de zevende partij en paars-groen heeft zelfs geen meerderheid in Vlaanderen. Het parlement wordt gewoon buitenspel gezet wanneer het over uw basis- en grondrechten gaat.’ Met artificiële intelligentie heeft die passage nog weinig te maken.

Extra transparantie is momenteel niet eenvoudig: er staat nog niet vast op welke manier de data zal worden verwerkt, noch welke concrete vragen aan de burger worden voorgeschoteld, noch zelfs welke externe partners de opdrachten concreet zullen uitvoeren. De hoorzitting die de N-VA vraagt over artificiële intelligentie voor alle partijen is waarschijnlijk geen slechte zaak. De oppositiepartijen kunnen daar hun bekommernissen aan bod laten komen, en de regeringspartijen kunnen ervan profiteren om de marge aan onduidelijkheid weg te nemen waarbinnen momenteel argwaan over ‘censuurfilters’ wordt aangewakkerd.

Fout opgemerkt of meer nieuws? Meld het hier