Waarom algoritmen ons leven níét zullen overnemen: ‘Zolang we de robots maar te vriend houden’

Algoritmen spelen een steeds grotere rol in ons leven. Moeten we vrezen voor robots die slimmer worden dan wij? Vlaamse wetenschappers nuanceren: ‘Een mens blijft complexer dan zelfs het meest gesofisticeerde algoritme.’

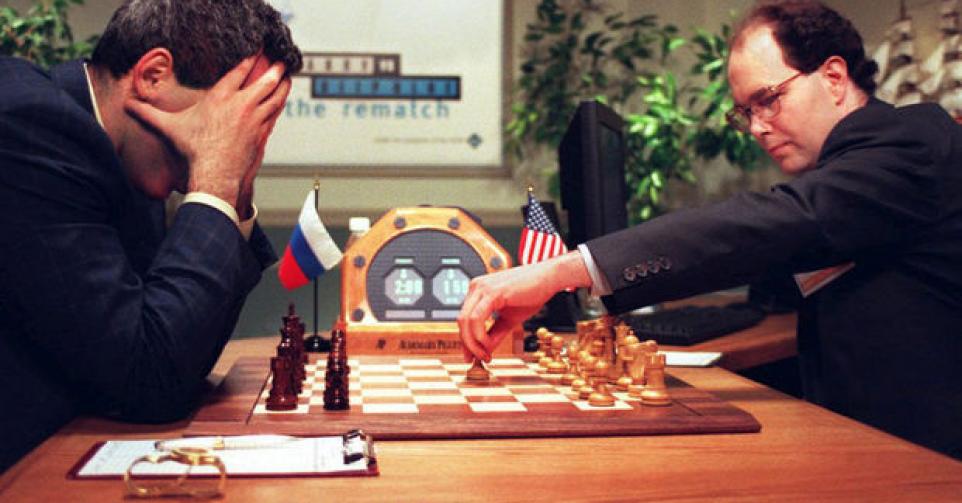

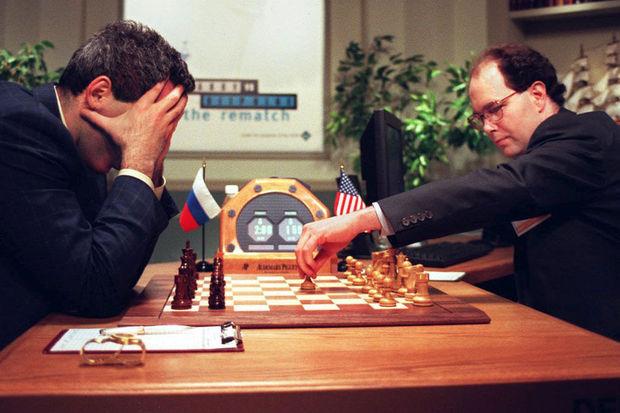

Voor sommigen is het de belangrijkste schaakwedstrijd aller tijden: die tussen de Russische grootmeester Garry Kasparov en de supercomputer Deep Blue. In 1997 versloeg de computer de mens voor het eerst. Onze soort ging nog harder zijn best doen om beter te schaken. We leerden van de onverwachte zetten die machines deden. Helaas werden ook de machines beter.

Deep Blue volgde instructies die hij kreeg van zijn ingenieurs, waarvan de meesten schaakfanaten waren. Hij kon vooral snel met een massa opties omgaan. In 2016 versloeg het computerprogramma AlphaGo de Koreaanse topspeler Lee Sedol in het complexe bordspel Go. AlphaGo is software die zichzélf traint, die miljoenen keren tegen zichzelf speelt om de beste speltechniek te ontwikkelen. Hij is, in tegenstelling tot Deep Blue, gemaakt door ontwikkelaars die amper wisten hoe ze Go moesten spelen.

Mensen die willen testen hoever ze intelligente software kunnen drijven, zijn aan de volgende uitdaging toe: machines laten winnen bij poker. Dat spel is van een andere orde dan schaken en Go, omdat er intuïtie bij komt kijken, en bluf. Het vakblad Science beschreef het algoritme DeepStack, dat 11 miljoen keer tegen zichzelf speelde om met het concept ‘onvolledige informatie’ te leren omgaan. Het mag ook geen herkenbare patronen ontwikkelen, die menselijke tegenspelers zouden kunnen detecteren. Soms laten programmeurs twee algoritmen met elkaar worstelen om het leerproces te bevorderen.

Algoritmen worden weleens vergeleken met onze hersenen. Maar misschien kán onze vorm van intelligentie zelfs niet gesimuleerd worden

Ann Nowé (VUB)

Die strategie werkt. DeepStack kan professionele pokerspelers verslaan, maar voorlopig alleen in een competitie met één mens. Als de machine meerdere menselijke spelers voor zich heeft, blijken die coalities tegen haar te vormen, en daar heeft ze nog geen oplossing voor. Software heeft beperkingen. Algoritmen kunnen bovendien alleen doen waarvoor ze gemaakt zijn: pokersoftware kan niet scrabbelen, niet bridgen. Wij kunnen al die dingen eventueel wel, maar niet altijd even goed. Wij zijn veelzijdig, zij munten uit in één taak. Dat is vooralsnog geruststellend.

Geen hocus pocus

‘Moderne algoritmen leren uit ervaringen die ze zelf creëren’, zegt Ann Nowé van het Computational Modeling Lab aan de Vrije Universiteit Brussel (VUB). ‘Je hebt het klassieke systeem van datamining: een massa gegevens doorzoeken en doorgronden, bijvoorbeeld om een spel als schaken te evalueren. In datamining zit de intelligentie vooral in de gegevensbank, in zelflerende algoritmen zit ze in de software. Daarbovenop heb je een proces van wat wij reinforcement learning noemen: de software probeert dingen uit in een soort evolutionaire wapenwedloop. Door zich aan te passen aan een steeds complexere omgeving, die ze zelf creëert, wordt ze steeds beter. Als je geen nieuwe dingen kunt doen, word je niet gemakkelijk beter dan andere spelers.’

Dat algoritmen niet-voorgeprogrammeerde dingen kunnen, daarvan is Nowé niet onder de indruk: ‘Het is geen hocus pocus, hoor. We kunnen met eenvoudige wiskunde bewijzen dat een algoritme naar een optimale strategie evolueert – dat kan al op basis van de kettingregel voor afgeleiden, die in de middelbare school onderwezen wordt.’

Nowé: ‘De werking van moderne algoritmen wordt weleens vergeleken met die van onze hersenen, maar niets zegt dat ze op dezelfde manier functioneren. Vergeleken met onze hersenen zijn algoritmen, voor die ene taak waarvoor ze gemaakt zijn, uitermate goed georganiseerd. Ons hoofd moet ononderbroken een massa prikkels tegelijk verwerken, in interactie met een voortdurend wijzigende omgeving. Dat is een wereld van verschil. Misschien kán onze vorm van intelligentie zelfs niet gesimuleerd worden.’

Ook volgens Wouter Rogiest van het Departement Telecommunicatie en Informatieverwerking aan de Universiteit Gent volgt de analogie tussen algoritmen en onze hersenen vooral uit de zoektocht naar een pakkende metafoor. Zelflerende algoritmen zijn voor hem wel de toekomst: ‘Net als voor mensen is het voor machines nuttig dat ze hun leven lang blijven leren. Vroeger was het eenvoudig: een algoritme voerde gewoon de opdracht uit waarvoor het gemaakt was. De verwerking van een massa gegevens steunt op dat eenvoudige principe. Maar sinds begin deze eeuw worden we overspoeld door algoritmen die antwoorden bieden zonder dat we weten hoe ze ertoe komen. Dat is niet alleen mogelijk gemaakt door de ontwikkeling van complexere algoritmen, ook de hardware is veel performanter geworden – net als onze hersenen hebben complexe algoritmen veel energie nodig.’

Het zelflerende proces van algoritmen wordt in het jargon deep learning genoemd. Het is gebaseerd op neurale netwerken die eruitzien als de netwerken die hersencellen met elkaar vormen. ‘Maar voor de rest is dat proces een black box‘, zegt Rogiest. ‘We weten niet precies wat er gebeurt. We krijgen alleen antwoorden, en die kunnen we vergelijken met wat mensen van dezelfde situatie maken. De meeste algoritmen bieden veel meer voor- dan nadelen, maar onfeilbaar zijn ze niet. Allemaal gaan ze weleens in de fout, ook in toepassingen in de gezondheidszorg en op sociale media.’

Rogiest: ‘Een belangrijke vraag is: kunnen we leven met fouten van machines? Dat mensen in de fout gaan, wordt aanvaard. Voor de technologie leggen we de lat hoger dan voor onszelf. Aan de andere kant blijft het natuurlijk mogelijk dat mensen algoritmen bewust voor foute doelstellingen gaan gebruiken, zoals duidelijk is geworden met de sjoemelsoftware die de vervuilende uitstoot van wagens moest verdoezelen.’

T-cellen tegen kanker

Net als een algoritme kan de menselijke fantasie onverwachte dingen doen. Artificiële intelligentie (AI) wordt vaak bijna automatisch vertaald naar metalen robots die slimmer worden dan hun makers en de wereld overnemen, in het slechtste geval met geweld. Maar de Terminators en co. zijn nog altijd creaties van sciencefiction. De realiteit is prozaïscher: AI en algoritmen moeten mensen helpen met taken die zo complex zijn dat we er zelf niet uit raken. Het zijn nieuwe werktuigen die de geneeskunde en de technologie vooruit moeten helpen, al dan niet aan de hand van de massa gegevens die wij aan de lopende band over onszelf verzamelen en opslaan.

Zo werkt Kris Laukens van Biomina, het Biomedical Informatics Network van de Universiteit Antwerpen, aan algoritmen die de menselijke afweer beter moeten helpen begrijpen. Hij is van oorsprong bioloog, maar is in de computerwetenschappen verzeild geraakt – een ideale combinatie om de complexiteit van ons lichaam te doorgronden. Onze afweer is door miljoenen jaren van evolutie gevormd om weerstand te bieden aan tal van aanvallers, van parasieten tot kankercellen. Hij steunt op een uitgebreid netwerk van cellen met informatie over wat gevaarlijk is en wat niet, zodat hij meestal alleen reageert indien nodig. Gaat de afweer in de fout, dan zijn gezondheidsproblemen als allergieën en auto-immuunziekten het gevolg – in het laatste geval keren afweercellen zich tegen cellen van het eigen lichaam.

‘Om potentieel gevaarlijke vreemde deeltjes te herkennen, is een belangrijke rol weggelegd voor T-cellen’, legt Laukens uit. ‘Daar bestaan miljoenen varianten van. Ze hebben elk een eigen stukje variabel DNA, waarmee ze een specifieke aanvaller detecteren. Sinds kort kunnen we dat DNA aflezen, en op elk moment een afweerprofiel van een patiënt maken. Aangezien de afweer voortdurend wijzigt, in functie van onder meer nieuwe blootstellingen of vaccinaties, gaat het om een dynamisch proces: het levert een “soep” aan gegevens op. We hebben een algoritme ontwikkeld waarmee we kunnen voorspellen welke T-cel op welke indringer zal reageren. Die kennis moet onder meer leiden tot betere vaccins en tot immuuntherapie: daarbij herprogrammeer je de afweer om bijvoorbeeld kankergezwellen aan te pakken.’

Hoe populair gezondheidsapps nu ook al zijn, het is niet wenselijk dat je de gezondheidszorg uitsluitend van algoritmen laat afhangen

Kris Laukens (Universiteit Antwerpen)

Voor hun algoritme vertrokken Laukens en zijn collega’s van technieken vergelijkbaar met het systeem dat Facebook voor zijn marketing gebruikt. Ze pasten ze aan om met DNA te kunnen werken. Vaak functioneren ook die systemen als een black box, waardoor wetenschappers niet goed weten wat ze doen. Voor sommige toepassingen kan dat geen kwaad. Als het gezichtsherkenningssysteem van Facebook een concrete naam van een gebruiker plakt op een schedel, of dat van Google een koppel zwarte Amerikanen als ‘gorilla’s’ labelt, is dat gênant – maar niet levensbedreigend.

‘Voor de gezondheidszorg ligt dat anders’, zegt Laukens. ‘Wij werken niet graag met zulke onzekerheden. We zitten met ons algoritme nog niet in de klinische fase, maar het zal nooit de bedoeling zijn dat het de expert vervangt. Hoe populair bepaalde gezondheidsapps nu ook al zijn, het is niet wenselijk dat je de gezondheidszorg uitsluitend van algoritmen laat afhangen. Op termijn zullen die wel bijdragen tot een meer gepersonaliseerde geneeskunde. Dat betekent niet noodzakelijk dat er voor elke patiënt een aparte behandeling komt, maar wel dat elke patiënt de voor zijn situatie beste behandeling krijgt uit de batterij die beschikbaar is – anders dreigt de geneeskunde onbetaalbaar te worden.’

Zelfrijdende bussen

Kurt De Grave van de KU Leuven en van Flanders Make, het strategisch onderzoekscentrum voor de maakindustrie in Lommel, werkt onder meer aan algoritmen om zelfrijdende bussen te besturen. Dat je niet altijd weet wat een algoritme doet, vindt hij evenmin storend. Er zijn wel trucjes, zegt hij, om ‘onder de motorkap’ van de software te kijken. Door een algoritme een reeks van specifieke problemen te laten behandelen, bijvoorbeeld de ontbrekende stukjes van een foto invullen, krijg je wat zicht op hoe het functioneert – zoals je ook met scanners kunt kijken naar wat de hersenen doen als ze een bepaalde taak uitvoeren.

Technologie voor autonoom rijdende voertuigen moet uiteraard aan strenge veiligheidsvoorschriften voldoen. ‘Geen enkel algoritme benadert zijn omgeving altijd correct’, zegt De Grave. ‘Maar dat doen mensen evenmin. De vraag is: vanaf wanneer is een algoritme zo goed dat het de weg op kan? Daar hebben we geen pasklaar antwoord op, we zullen er statistiek voor moeten gebruiken. Nemen algoritmen zelden foute beslissingen, dan kan het. Zeker als ze kunnen leren uit hun fouten.’

De Grave: ‘Wij doorlopen met onze technologie een lang proces van almaar concretere simulaties, dat begint met het formele beschrijven van de verkeersregels en het gedrag dat we van het voertuig verwachten. Ons systeem is nog niet gehomologeerd om autonoom de openbare weg op te gaan, maar we werken samen met een Vlaamse busfabrikant die het over een jaar of twee wil testen. In het openbaar vervoer volgen voertuigen vaak hetzelfde traject: door die voorspelbare omgeving wordt zelfrijdend gedrag vergemakkelijkt.’

De Grave is niet onder de indruk van het zelfrijdende karakter van ‘een bepaald merk van high-end elektrische wagens’: ‘In feite gaat het daarbij om een rijhulpsysteem dat sommigen helaas gebruiken alsof het zelfrijdend is. Dan moet je niet verbaasd zijn als er ongevallen gebeuren. Er is een race bezig om als eerste een zelfrijdend voertuig gebruiksklaar te krijgen, maar laten we de elementaire voorzichtigheid niet uit het oog verliezen.’

De blockchaintechnologie zal een minstens even grote revolutie veroorzaken als het internet in de jaren 90

Wouter Rogiest (Universiteit Gent)

De Grave: ‘De prognoses over wanneer zelfrijdende wagens het verkeer in zullen kunnen, liepen tot voor kort sterk uiteen. Volgens sommigen zou het nog meer dan tien jaar duren. Maar Waymo, een zusterbedrijf van Google, maakte onlangs bekend dat het in de Amerikaanse stad Phoenix over enkele maanden met een taxidienst met zelfrijdende wagens start: klanten zullen via een app een rit kunnen boeken. Het tijdperk van de zelfrijdende wagen staat dus voor de deur.’

‘Verantwoordelijke algoritmen’

Ann Nowé van de VUB zou vandaag zeker in een zelfrijdende wagen stappen, maar wel achter het stuur, waar ze indien nodig de wagen kan overnemen. ‘Wie zal verantwoordelijk zijn als er iets misloopt: de gebruiker van de zelfrijdende wagen of de maker van het algoritme? Daarover woedt een debat. We zijn er nog niet uit of het maatschappelijk verantwoord is dat een algoritme beslissingen neemt waarvan je leven kan afhangen. Kijken naar patronen en een beslissing nemen, is iets anders dan bepalen hoe je je strategisch het beste gedraagt, ook in het verkeer.’

In juridische situaties worden algoritmen soms al gebruikt, bijvoorbeeld om te bepalen hoeveel kans er is dat een veroordeelde crimineel hervalt. ‘De vraag is of we de objectiviteit van een algoritme verkiezen boven de eventuele subjectiviteit van een rechter, die een vorm van menselijkheid laat meespelen in zijn of haar oordeel’, zegt Ann Nowé.

Nowé: ‘Facebook heeft geëxperimenteerd met een algoritme om uit foto’s de geaardheid van mensen af te leiden. Daarop werd verontwaardigd gereageerd, omdat wij onze kinderen net leren dat ze mensen niet zomaar in hokjes mogen steken. Als het gaat om de reclameboodschappen die je online te zien krijgt, komen algoritmen minder bedreigend over dan als er een oordeel moet worden geveld. Er is trouwens, in het kader van de Europese privacywetgeving, regelgeving op komst over “verantwoordelijke algoritmen”. Wat algoritmen kunnen voor ze op de markt worden losgelaten, moet voldoende duidelijk zijn. Dat is een goede zaak.’

In tegenstelling tot prominente doemdenkers als fysicus Stephen Hawking, gelooft Nowé niet in het idee dat algoritmen op termijn slimmer zullen worden dan de mensheid – sommigen pinnen het tijdstip voor die omslag vast op 2045. ‘Een mens, met zijn persoonlijkheid en emoties, blijft complexer dan zelfs het meest gesofisticeerde algoritme. Elke mens is ook anders. Er bestaat niet zoiets als het uniforme brein. Hard- en software kunnen in zekere mate verschillen vertonen, maar de variatie zit toch vooral in de data waarmee ze getraind worden. Onze hersenen zijn het resultaat van miljoenen jaren evolutie – dat zal niet zomaar overruled worden.’

Veel mensen onderschatten bijvoorbeeld de impact van de blockchaintechnologie die op komst is

Overbodige jobs

Hoewel doemdenkers in de traagheid van de menselijke evolutie net een gevaar zien – technologische ontwikkelingen gaan sneller – maakt ook Wouter Rogiest van de Universiteit Gent zich geen zorgen over concepten als Hal 9000, de supercomputer uit Space Odyssey die de mensheid overrulet: ‘Als je robots goed programmeert, zul je zulke problemen niet krijgen. Het is belangrijk dat de mensheid en robots zich hand in hand ontwikkelen. Het spreekt vanzelf dat zij een boel dingen beter zullen kunnen dan wij; we hebben er dus alle belang bij hen te vriend te houden. Dat garandeert niet dat het nooit zal mislopen, maar áls dat gebeurt, zal het in eerste instantie aan ons liggen: malafide hackers zouden de interpretatie van verkeersborden door zelfrijdende wagens bijvoorbeeld zo kunnen wijzigen dat ze in de fout gaan. Er bestaan al militaire drones die zelf beslissingen nemen, maar we mogen niet zover gaan dat we robots programmeren die ons zouden kunnen vernietigen. Het gezond verstand moet zegevieren.’

Volgens Rogiest zal de maatschappelijke impact van AI en robotisering vooral elders liggen. ‘Veel mensen onderschatten bijvoorbeeld de impact van de blockchaintechnologie die op komst is. Ze zal een minstens zo grote revolutie veroorzaken als het internet in de jaren 90. De bitcoin en andere cryptomunten zijn maar één toepassing van die technologie, die steunt op een eenvoudig algoritme dat zelfs nog geen zelflerend vermogen heeft. Het leest als een soort grootboek in de digitale ruimte, waarin informatie – inclusief transacties en contracten – automatisch gesplitst wordt opgeslagen, zodat er niets aan kan worden veranderd. Dat zal veel jobs overbodig maken. Het gaat daarbij niet alleen om het bankwezen of het notariaat, instanties die in dit verband vaak genoemd worden, maar ook om spelers met een minder officieel karakter. Bedrijven als het Nederlandse Guts binden de strijd aan met ticketfraude en woekerprijzen bij de doorverkoop van bijvoorbeeld concerttickets, door de toegangscontrole te versleutelen in de blockchain. Voor uitgevers van tickets en vouchers die daar niet aan meedoen, kan dat het einde inluiden. Het Belgische iText werkt dan weer aan een vernieuwende oplossing voor digitale handtekeningen, waarin de traditioneel aanwezige derde partijen die de handtekening certificeren vervangen worden door onweerlegbare, geautomatiseerde bewerkingen in de blockchain.’

‘De maatschappelijke gevolgen van de nieuwe toepassingen managen’, zo besluit Rogiest, ‘is een veel grotere uitdaging dan de mogelijkheid counteren dat robots ooit slimmer worden dan wij. Maar ja, het klinkt natuurlijk een stuk minder spectaculair.’

Fout opgemerkt of meer nieuws? Meld het hier